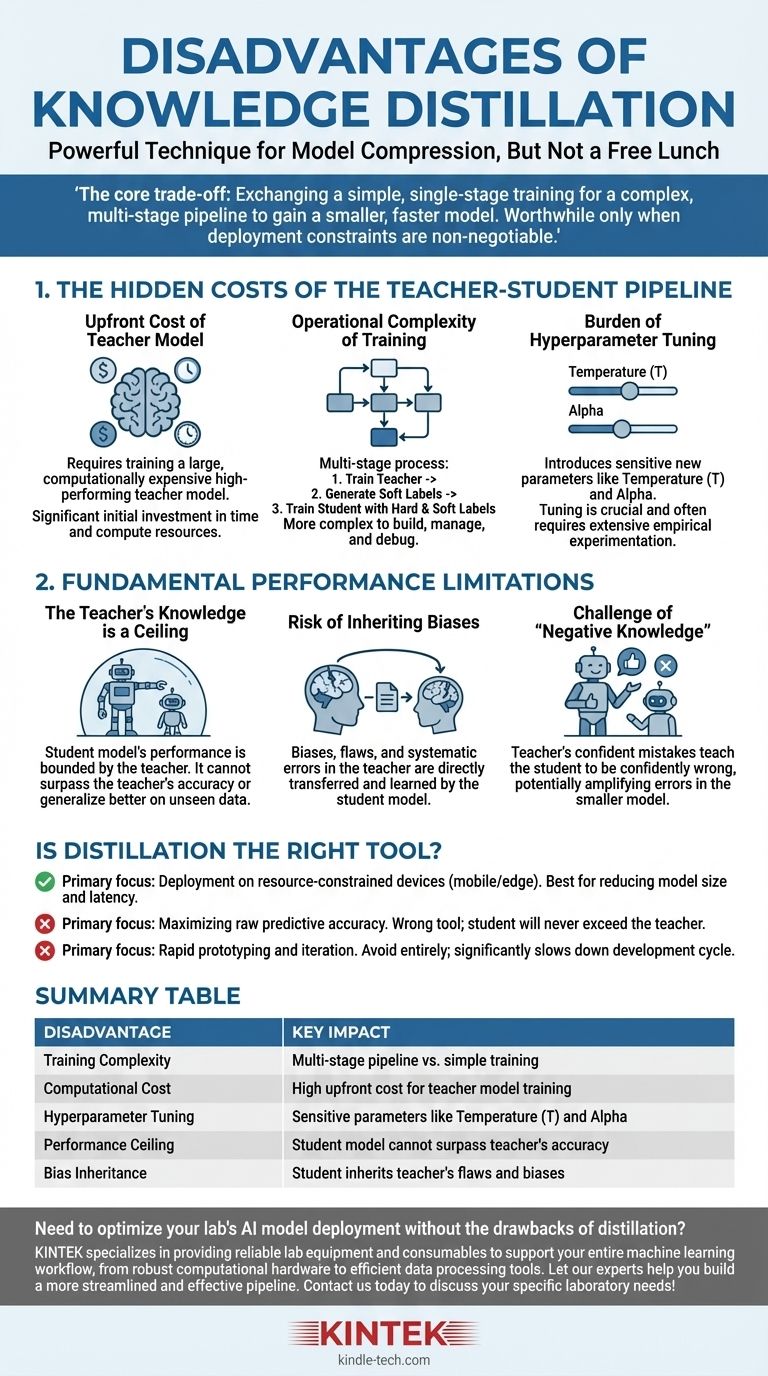

Embora a destilação de conhecimento seja uma técnica poderosa para a compressão de modelos, ela não é uma solução gratuita. As principais desvantagens são o aumento significativo na complexidade do treinamento e no custo computacional, a introdução de novos hiperparâmetros sensíveis e o teto de desempenho rígido imposto pela qualidade do modelo professor.

A principal troca da destilação é clara: você está trocando um processo de treinamento mais simples e de estágio único por um pipeline complexo e de múltiplos estágios para obter um modelo menor e mais rápido. Esse investimento em complexidade só vale a pena quando as restrições de implantação, como latência ou memória, são inegociáveis.

Os Custos Ocultos do Pipeline Professor-Aluno

As desvantagens mais imediatas da destilação não são conceituais, mas práticas. Elas envolvem o tempo, os recursos e o esforço de engenharia adicionais necessários para gerenciar um fluxo de trabalho de treinamento mais complexo.

O Custo Inicial do Modelo Professor

Antes mesmo de começar a destilação, você precisa de um modelo professor de alto desempenho. Este modelo é, por design, grande e computacionalmente caro para treinar.

Esta fase inicial de treinamento representa um custo significativo e não trivial, tanto em tempo quanto em recursos computacionais, que deve ser pago antes que o treinamento "real" do modelo aluno possa começar.

A Complexidade Operacional do Treinamento

A destilação é um processo de múltiplos estágios, ao contrário do treinamento de modelo padrão. O fluxo de trabalho típico é:

- Treinar o grande modelo professor até a convergência.

- Realizar inferência com o modelo professor em todo o seu conjunto de dados de treinamento para gerar os "rótulos suaves" ou logits.

- Treinar o modelo aluno menor usando tanto os "rótulos rígidos" originais quanto os rótulos suaves do professor.

Este pipeline é inerentemente mais complexo de construir, gerenciar e depurar do que um script de treinamento padrão.

O Fardo da Otimização de Hiperparâmetros

A destilação introduz hiperparâmetros únicos que governam o processo de transferência de conhecimento, e eles exigem um ajuste cuidadoso.

O mais crítico é a temperatura (T), um valor usado para suavizar a distribuição de probabilidade das saídas do professor. Uma temperatura mais alta revela informações mais sutis sobre o "raciocínio" do professor, mas encontrar o valor ideal é um processo empírico.

Outro hiperparâmetro chave é alfa, que equilibra a perda dos rótulos suaves do professor com a perda dos rótulos rígidos de verdade. Esse equilíbrio é crucial para o sucesso e muitas vezes requer experimentação extensiva.

As Limitações Fundamentais de Desempenho

Além dos custos práticos, a destilação possui limitações inerentes que limitam o potencial do modelo aluno final.

O Conhecimento do Professor é um Teto

O desempenho de um modelo aluno é fundamentalmente limitado pelo conhecimento de seu professor. O aluno aprende a imitar a distribuição de saída do professor.

Portanto, o aluno não pode superar o professor em precisão ou generalizar melhor em dados não vistos. Ele só pode esperar se tornar uma aproximação altamente eficiente das capacidades do professor.

O Risco de Herdar Vieses

Quaisquer vieses, falhas ou erros sistemáticos presentes no modelo professor serão diretamente transferidos e aprendidos pelo modelo aluno.

A destilação não "limpa" o conhecimento; ela simplesmente o transfere. Se o professor tiver um viés contra uma determinada demografia ou uma fraqueza em um domínio de dados específico, o aluno herdará exatamente a mesma fraqueza.

O Desafio do "Conhecimento Negativo"

Se o modelo professor estiver confiantemente errado sobre uma previsão específica, ele ensinará o aluno a estar confiantemente errado também.

Isso é potencialmente mais prejudicial do que um modelo que é simplesmente incerto. O processo de destilação pode amplificar os erros do professor, incorporando-os ao modelo menor e mais eficiente, onde podem ser mais difíceis de detectar.

A Destilação é a Ferramenta Certa para o Seu Objetivo?

Em última análise, a decisão de usar a destilação depende inteiramente do objetivo principal do seu projeto.

- Se o seu foco principal é a implantação em ambientes com recursos limitados (como dispositivos móveis ou de borda): A destilação é uma técnica líder para alcançar a redução necessária no tamanho do modelo e na latência, supondo que você possa arcar com a complexidade inicial do treinamento.

- Se o seu foco principal é maximizar a precisão preditiva bruta: A destilação é a ferramenta errada. Seu esforço é melhor gasto no treinamento do melhor modelo autônomo possível, pois o aluno nunca excederá o desempenho do professor.

- Se o seu foco principal é a prototipagem e iteração rápidas: Evite a destilação completamente. O pipeline de múltiplos estágios e a complexa otimização de hiperparâmetros atrasarão significativamente seu ciclo de desenvolvimento e experimentação.

Compreender essas desvantagens permite que você implante a destilação de conhecimento estrategicamente, reconhecendo-a como uma ferramenta especializada para otimização, não um método universal de melhoria.

Tabela Resumo:

| Desvantagem | Impacto Chave |

|---|---|

| Complexidade do Treinamento | Pipeline multi-estágio vs. treinamento simples |

| Custo Computacional | Alto custo inicial para o treinamento do modelo professor |

| Otimização de Hiperparâmetros | Parâmetros sensíveis como temperatura (T) e alfa |

| Teto de Desempenho | Modelo aluno não pode superar a precisão do professor |

| Herança de Vieses | Aluno herda falhas e vieses do professor |

Precisa otimizar a implantação do modelo de IA do seu laboratório sem as desvantagens da destilação? A KINTEK é especializada em fornecer equipamentos e consumíveis de laboratório confiáveis para apoiar todo o seu fluxo de trabalho de aprendizado de máquina, desde hardware computacional robusto até ferramentas eficientes de processamento de dados. Deixe nossos especialistas ajudá-lo a construir um pipeline mais simplificado e eficaz. Entre em contato conosco hoje para discutir suas necessidades específicas de laboratório!

Guia Visual

Produtos relacionados

As pessoas também perguntam

- Qual é a diferença entre extrato de cannabis e destilado? Um guia sobre potência versus efeitos de espectro total

- O destilado de THC é melhor? Descubra os prós e contras da potência pura vs. os efeitos de espectro completo

- Quais são os métodos de separação e purificação? Domine as Técnicas Chave para o Seu Laboratório

- Qual é a regra Delta 20? Um Guia para Diagnosticar e Aperfeiçoar o Seu Espresso

- Que fatores afetam a evaporação e a condensação? Domine a Ciência das Mudanças de Fase da Água